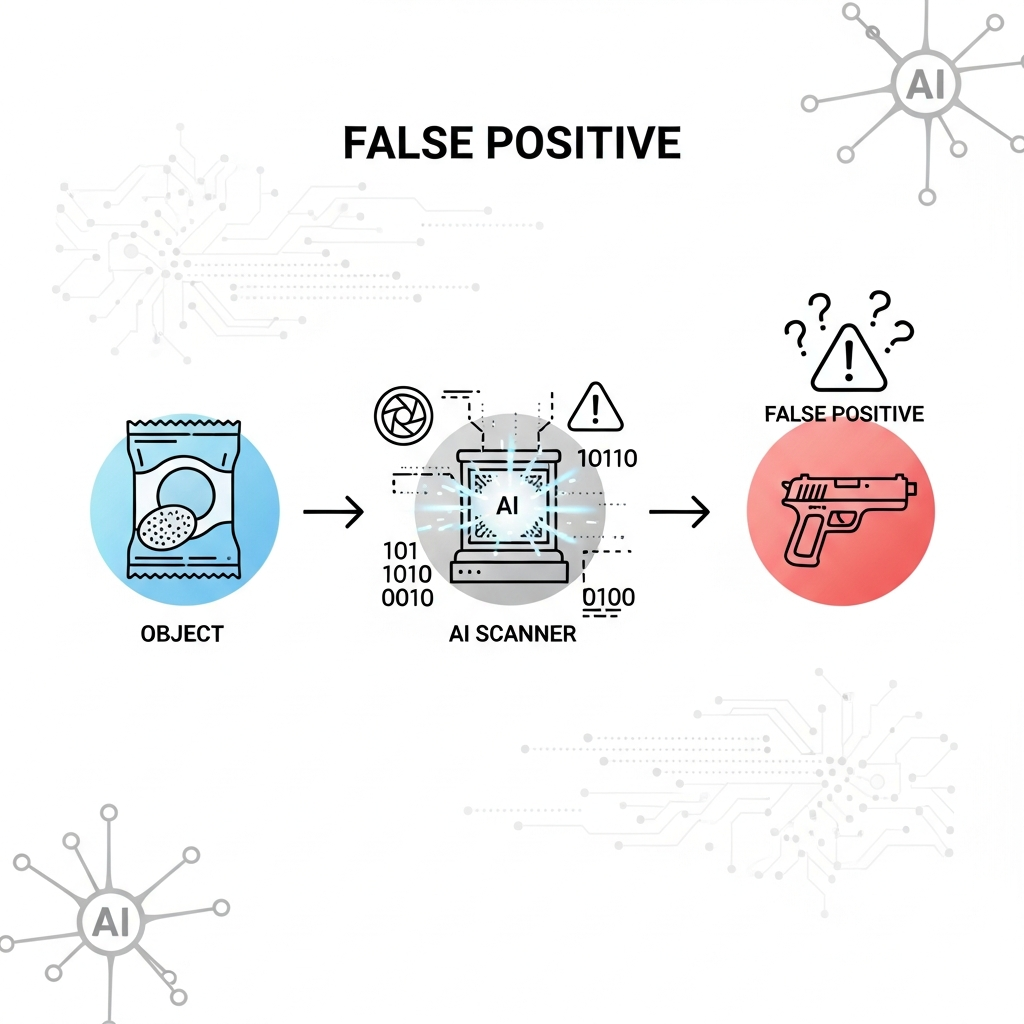

2025년, 미국에서 AI 오작동으로 10대 소년이 무장 경찰에게 수갑이 채워지는 충격적인 사건이 발생했어요. 인공지능 감지 시스템이 평범한 과자 봉지를 총으로 오인하면서 벌어진 일인데요. 과연 기술은 완벽할 수 있을까요? 이 사건의 자세한 경위와 함께, 우리가 인공지능 시스템에 대해 다시 한번 생각해봐야 할 점들을 알려드릴게요.

AI 오작동, 과자 봉지가 총으로 둔갑한 사건의 시작

2025년 10월 24일, 미국 볼티모어의 한 학교에서 상상하기 어려운 사건이 발생했어요. 16세의 십대 소년 타키 앨런(Taki Allen) 군은 축구 연습을 마치고 도리토스 과자 봉지를 들고 있었을 뿐이었죠. 하지만 학교의 AI 감지 시스템은 이 평범한 과자 봉지를 ‘총’으로 오인했고, 이 경고는 곧바로 학교 관계자들에게 전달되었답니다.

이 오인식으로 인해 순식간에 수많은 경찰차가 학교로 출동했고, 앨런 군은 무장 경찰들에게 수갑이 채워지는 충격적인 경험을 하게 되었어요. 그는 WMAR-2 News와의 인터뷰에서 “경찰차 8대가 왔고, 모두 나에게 총을 겨누며 엎드리라고 했다”고 당시의 긴박했던 상황을 전했답니다. 다행히 곧 오인임이 밝혀져 별일 없이 마무리되었지만, 앨런 군에게는 잊을 수 없는 경험으로 남았다고 해요.

한 십대 소년의 충격적인 경험: 무엇이 문제였을까요?

앨런 군은 축구 연습 후 빈 도리토스 봉지를 주머니에 넣었을 뿐이었어요. 그런데 20분 후, 총을 든 경찰들이 들이닥쳐 그를 체포하고 수갑을 채웠다고 합니다. 볼티모어 카운티 경찰은 앨런 군이 수갑을 채워졌지만 체포된 것은 아니라고 밝혔어요. 그들은 “당시 제공된 정보에 따라 적절하게 대응했다”고 설명했지만, 앨런 군은 이제 과자를 먹거나 음료를 마실 때도 밖에 나가는 것이 안전하지 않다고 생각하게 되었다고 해요.

학교 측의 초기 대응도 논란의 중심에 섰습니다. 교장 케이트 스미스(Kate Smith)는 학부모들에게 보낸 편지에서 학교 안전팀이 초기 경고를 신속하게 검토하고 무기가 없음을 확인했다고 말했어요. 하지만 교장 본인은 이 사실을 놓치고 학교 자원 담당관(SRO)에게 연락했고, SRO가 결국 경찰을 불렀다고 합니다. AI가 1차적으로 오인한 것을 사람이 확인했음에도 불구하고, 의사소통 오류로 인해 불필요한 공포와 혼란이 발생한 것이죠.

시스템은 “정상 작동”했다? 옴니러트의 해명

AI 시스템 공급업체인 옴니러트(Omnilert)는 이번 사건에 대해 유감을 표하면서도, 그들의 시스템은 “설계된 대로 작동했다”고 주장했어요. 옴니러트는 시스템이 처음에는 총기로 보이는 물체를 감지했고, 그 이미지는 검토팀에 의해 확인되었다고 설명했어요. 그리고 이 정보가 볼티모어 카운티 공립학교(BCPS) 안전팀에 “몇 초 내에” 전달되었다고 합니다.

옴니러트는 “비록 해당 물체가 나중에 총기가 아닌 것으로 밝혀졌지만, 이 과정은 의도한 대로 기능했다: 즉각적인 인간 확인을 통해 안전과 인식을 우선시했다”고 말했어요. 하지만 앨런 군은 “과자 봉지가 총으로 오인되어서는 안 된다고 생각한다”며 시스템의 정확성에 의문을 제기했답니다. 이 사건은 AI 총기 감지 기술의 한계와 실생활 적용의 복잡성을 여실히 보여주는 사례라고 할 수 있어요.

AI 오인식, 반복되는 기술의 그림자

AI 기술의 오인식 문제는 이번이 처음이 아니에요. 지난해에는 미국의 한 무기 스캐닝 회사인 이볼브 테크놀로지(Evolv Technology)가 자사 AI 스캐너가 모든 무기를 감지할 수 있다는 주장을 철회하도록 명령받았답니다. BBC 뉴스 조사 결과, 이들의 주장이 허위임이 밝혀졌기 때문이죠. 이볼브 테크놀로지의 스캐너는 수천 개의 미국 학교, 병원, 경기장 입구에서 사용되고 있었어요.

이처럼 AI 기반 감지 시스템은 사람의 눈으로는 놓칠 수 있는 것을 잡아내는 데 도움을 줄 수 있지만, 동시에 치명적인 오류를 저지를 수도 있다는 한계를 가지고 있어요. 특히 안전과 직결되는 총기 감지 시스템의 경우, 작은 오작동이 한 사람의 삶에 큰 영향을 미 미칠 수 있기에 더욱 신중한 접근이 필요하답니다.

AI 감지 시스템, 과연 완벽할까? 전문가들의 우려

볼티모어 카운티 지역 의원인 이지 파코타(Izzy Pakota)는 이 사건에 대해 추가 조사를 요구하며, 볼티모어 카운티 공립학교에 AI 기반 무기 감지 시스템에 대한 절차를 재검토할 것을 촉구했어요. 이는 AI 기술이 가져올 수 있는 잠재적인 위험에 대한 사회적 우려를 반영하는 것이죠.

전문가들은 “실제 총기 감지는 복잡하다”고 말하며, AI 시스템이 훈련된 환경과 실제 환경 간의 격차를 줄이는 것이 중요하다고 강조해요. 또한, AI의 결정이 인간의 개입 없이 즉각적으로 실행되는 것을 경계하며, 항상 인간 검토 과정이 필수적이어야 한다고 입을 모읍니다. 기술은 도구일 뿐, 그 도구를 어떻게 사용하고 관리하는지는 전적으로 인간의 몫이라고 할 수 있죠.

미래의 AI 기술, 더 나은 발전을 위한 고민

이번 AI 오작동 사건은 우리에게 중요한 질문을 던져요. 인공지능 기술이 발전함에 따라 우리의 삶은 더욱 편리해지고 안전해질 것이라는 기대가 크지만, 동시에 기술의 불완전함이 초래할 수 있는 문제들에 대해서도 깊이 고민해야 한다는 점이죠. 특히 생명과 안전에 직결되는 분야에서는 AI 시스템의 정확성과 신뢰도를 확보하는 것이 무엇보다 중요하답니다.

앞으로는 AI 시스템의 오인식률을 낮추기 위한 기술적인 발전과 더불어, 인간의 판단과 기술의 판단이 조화롭게 공존할 수 있는 시스템을 구축하는 것이 중요할 거예요. 기술의 혜택을 온전히 누리면서도 그 부작용을 최소화할 수 있도록, 사회적 논의와 제도적 보완이 함께 이루어져야 할 시점입니다.

출처: https://www.bbc.com/news/articles/cgjdlx92lylo

같이 보면 좋은 글

- Have no fear of perfection – you’ll never reach it: 완벽주의 두려움을 버리는 지혜

- 2025년 10월 27일 쿠팡 골드박스 추천! 생활/식품 베스트 꿀템 할인

#AI오작동 #인공지능오류 #AI감지시스템 #총기오인식 #과자봉지사건 #볼티모어AI #학교안전AI #기술의한계 #인공지능문제점 #AI와인간 #AI윤리 #미래기술 #오인식사례 #기술논란 #AI과실 #딥러닝오류 #스마트보안 #AI감시 #사생활침해 #기술발전 #IT이슈 #사회문제 #AI안전 #AI부작용 #2025년이슈